来源:益盟 2025/02/07 06:33:18

摘要: 布局2025,你必须知道的那些事儿~

大家好,我们继续聊DeepSeek~

上篇文章我开了个头,大概介绍了下DeepSeek模型爆火的原因,其实就两点:

1、高性能:性能比肩OpenAI最新一代推理模型——o1模型;

2、低成本:训练成本只有OpenAI-o1模型的3%-5%。

这就好比过去买一台劳斯莱斯幻影需要1000万,现在告诉你有个渠道30万就可以买,而且配置性能都没差,你会不会惊掉了下巴,哈哈。怪不得有人说DeepSeek是大模型界的拼多多。

惊叹之余,疑问也随之涌现,这究竟是为什么呢?为什么性能差不多的模型,美国人做出来要4亿美金,中国人做出来却只要550万美元?这是我在上篇文章的末尾留给大家的问题,今天,我就来公布答案。

其实答案很简单,因为思考的方式不一样。

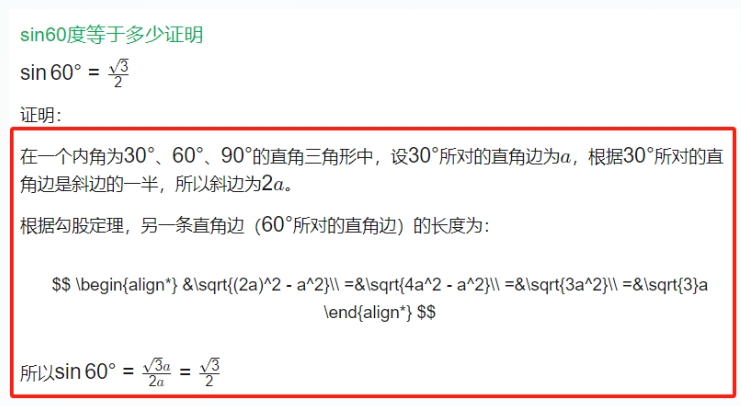

初中我们都学过三角函数,如果我问你,sin60度等于多少?你会怎么回答呢~

回答这个问题,有两种思考方式:

第一种,逻辑推理。

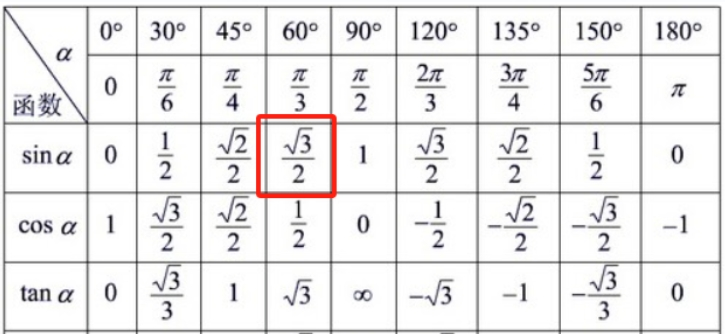

第二种,直接查表。

发现了吗,两种方式得出的答案是一摸一样的,但思考的方式完全不同。

第一种逻辑推理,好比一位擅长计算的理科生,他们喜欢一步一步推演解题步骤,从问题到答案,清晰的呈现在纸面上;

而第二种,直接查表,看起来简单粗暴,直接囫囵吞枣把结论背下来,但的确挺有效率是不是,可以一秒给出答案。

以上这两种方法的差异,就是OpenAI与DeepSeek的区别。OpenAI擅长计算,所以哪怕是一个看起来极为简单的三角函数,他也一定要知其所以然,一步一步证明给出答案。这种方式自然是最理论,最扎实的,最能应对复杂多变的问题。但同时,也需要消耗大量算力,换言之,得是一位计算能力极为出众的天才同学,才能达到如此水平。

而DeepSeek采取的方式则不同,他更多靠的是记忆,如果我能把一整张三角函数的数据表背下来,那我一样能解题对不对?这种方式对算力的消耗很少,并不需要强大的推理能力,我要做的只是记住每一个答案和问题,以及关键步骤即可。然后在遇到相同问题的时候,参考历史,给出答案。这个过程用更专业的词儿来说叫做“蒸馏”,当然,实际的“蒸馏”并非是我所描述的那么简单,DeepSeek也没有那么“死记硬背”,中间会存在一些优化,但是大体的原理就是如此。

说到这里,你应该能够理解为何DeepSeek可以用更少,更一般的GPU,也能达到比肩OpenAI的原因了吧。DeepSeek靠的更多是记忆,而非计算。这么做的好处是不需要大量计算,所以对GPU的需求就会锐减,体现出的就是DeepSeek97%的成本压缩;但劣势也是显而易见的,如果碰到过去没有记忆过的新问题,搞不清因果关系的模型就会不知所措。

所以,严格意义上来说,DeepSeek并不像一个真正的人工智能大模型,因为他并没有完全模拟一个我们所期待的,人类思考的全过程,他只是在不断记忆已经形成的问题和答案,以及解题的部分关键步骤。这也是为何DeepSeek做到极致,性能也仅是比肩OpenAI,而无法做到超越的原因。

可能大家会觉得我的观点有点泼冷水,毕竟网上一堆宣称中国模型KO美国的爽文。这里我得澄清一下哈,我并没有任何贬低国产大模型的意思,我只是希望大家不要被舆论带偏节奏。而且,DeepSeek采用的这种“背诵”的方式也并不“LOW”,或者说,这是人工智能发展到如今这个水平下,必然会出现的一条新路径。

为什么这么说呢。

看过我之前写的【布局2025】之【投资AI,有哪些“新”变化?】这篇文章的盟友应该有印象,我在这篇文章里和大家说了一个观点,就是“GPU单卡性能和大模型技术迭代开始放缓”,这种放缓,就会注定诞生类似DeepSeek这种公司。

这里我给没看的盟友简单回顾下那篇文章的观点:

大家还记得吗,之前英伟达发布的卡都是诸如A100,H100,现在的卡是什么呢,是GB200,GB300。前者如A100,H100都是单卡,后者GB200,GB300则是多卡集群。为什么英伟达从卖单卡,开始转变为卖多卡集群?原因是由于摩尔定律的失效,单卡的性能已经很难提升,所以才把多张卡连在一起。但是单卡变成多卡互联,并非简单的1+1=2,而是1+1<2。多个卡的连接,会大幅降低效率,所以需要提升多张卡之间的传输速度,去年炒了很久的先进封装,PCB,铜缆,光模块,CPO这些五花八门的技术,目的其实都是一个,就是为了提升传输速度,让1+1无限逼近2,这属于多卡集群算力的提升。这也是在单卡性能无法继续大幅提升下的必然产物。

当然,即便是通过各种技术提升了传输速度,也无法比拟摩尔定律带来的巨大升级。所以你可以理解为摩尔定律带来的单卡性能提升是大升级,靠提升传输速度带来的多卡集群性能提升是小升级。总之,大模型的迭代速度是放缓了,这一点你从GPT-5迟迟难产也能看出一二。

既然大模型的迭代放缓了,那理论上就会有无数追赶者出现。这就好比一个新技术成熟后,会有无数模仿者,追随者一样。DeepSeek就是其中之一,而且他选择了一种新路径,一种看似“有点不智能”,但实则能非常有效降低成本的方式,也就是我前面提到的,靠记忆,靠算法,用非常少资金投入就“复制”出了一个OpenAI模型。

所以,你可以这么理解,DeepSeek做的不是AI模型的创新,而是AI模型的平权,他的目的是让更多的企业,更多的人用非常少的资金就能“复制”出一个OpenAI模型或是XX模型。而随着更多的人都能“用得起”一流的模型,用的人多了,测试的人多了,可能就会由此诞生出某个爆款应用,这也是为何DeepSeek爆火后,无论是A股还是美股,都是应用端的股票领涨的原因。

OK,以上就是【中篇】的全部内容,这个系列还剩最后一篇,在【下篇】里,我会落脚到大家最关心的股票标的,到底DeepSeek的出现,会如何影响今年对科技股的投资?大家敬请关注~

投资顾问:吴美林

登记编号:A0880619080007

风险提示:本内容仅供投资参考,不作为投资建议,据此入市,风险自负,股市有风险,投资需谨慎!