2025/03/25 06:31:35

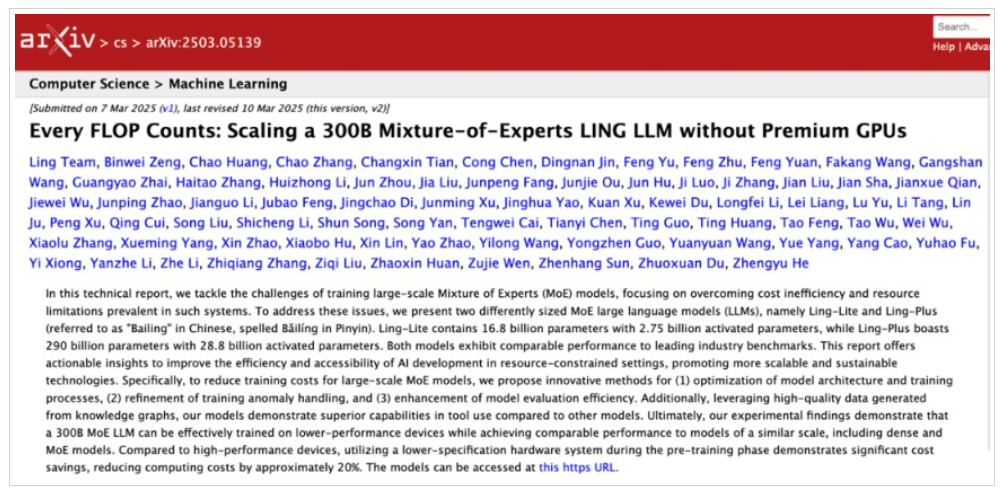

【蚂蚁集团AI重大突破:使用国产AI芯片训练大模型 成本可进一步降低】近日,蚂蚁集团Ling团队发表了一篇技术成果论文。论文显示,蚂蚁集团推出了两款不同规模的MoE大语言模型——百灵轻量版(Ling-Lite)与百灵增强版(Ling-Plus),前者参数规模为168亿(激活参数27.5亿),Plus基座模型参数规模高达2900亿(激活参数288亿),两者性能均达到行业领先水平。除了自研性能领先的大模型以外,该技术论文最大的突破在于提出了一系列创新方法,以提升资源受限环境下AI开发的效率与可及性。实验表明,其3000亿参数的MoE(混合专家)大模型可在使用国产GPU的低性能设备上完成高效训练,性

近日,

除了自研性能领先的大模型以外,该技术论文最大的突破在于提出了一系列创新方法,以提升资源受限环境下AI开发的效率与可及性。实验表明,其3000亿参数的MoE(混合专家)大模型可在使用国产GPU的低性能设备上完成高效训练,性能与完全使用英伟达芯片、同规模的稠密模型及MoE模型相当。

在低性能硬件上高效训练的自研大模型

目前,

据技术成果论文,虽然DeepSeek、阿里通义千问、MiniMax等系列的MoE大模型在特定任务中展现出卓越性能,但是MoE模型的训练通常依赖高性能计算资源(如英伟达H100/H800等先进GPU),高昂成本制约了在资源受限环境中的普及应用。同时,近年来英伟达高性能芯片持续短缺,相比之下,低性能加速器供应更充足且单机成本更低。这种差异凸显了构建跨异构计算单元与分布式集群无缝切换技术框架的必要性。

因此,Ling团队设定的目标是“不使用高级GPU”来扩展模型,并通过提出创新性的训练策略,旨在突破资源与预算限制实现高效大语言模型训练,从而推动AI技术向普惠化方向发展。

具体而言,团队提出的创新策略包括:1)架构与训练策略革新:动态参数分配与混合精度调度技术;2)训练异常处理机制升级:自适应容错恢复系统缩短中断响应时间;3)模型评估流程优化:自动化评测框架压缩验证周期超50%;4)工具调用能力突破:基于知识图谱的指令微调提升复杂任务执行精度。

据技术论文,Ling团队在五种不同的硬件配置上对9万亿个token进行Ling-Plus的预训练,其中使用高性能硬件配置训练1万亿token的预训练成本约为635万元人民币,但利用蚂蚁的优化方法后,使用低规格硬件的训练成本将降至508万元左右,节省了近20%,最终实现与阿里通义Qwen2.5-72B-Instruct和DeepSeek-V2.5-1210-Chat相当的性能。

此前,DeepSeek通过一系列算法创新及工程优化,使用性能较低的英伟达H800训练出了性能与顶尖模型相当的V3与R1,为大模型的训练开辟了新的道路,让更多的企业和研究机构看到了降低成本、提高效率的可能性。如果

蚂蚁持续加码AI应用与人形

记者了解到,百灵大模型作为

3月21日,蚂蚁宣布AI医疗领域的最新进展:发布面向医疗机构、医生、用户三端的AI产品体系升级,其中,面向医疗机构,我们联合华为医疗卫生军团、阿里云、苹果等推出“蚂蚁医疗大模型一体机”全栈式解决方案;面向医生,发布AI医生助手系列工具;同时,面向用户的健康应用“AI健康管家”也推出智能思考、健康自测等十余项新功能。

除了AI以外,蚂蚁近期在人形

据浦东发布消息,3月11日,上海蚂蚁灵波科技有限公司在上海浦东举行揭牌仪式。据介绍,蚂蚁灵波科技是

具身智能人形

业内人士分析称,具身智能人形